Andrej Karpathy影片觀後感——不是工程師,也該懂的 AI 素養入門

當我們談「永續」,大多數人會直覺想到環境、能源、碳排放。

但事實上,真正決定企業或個人能否永續發展的,還有一項關鍵因素——我們與科技的關係。

特別是在生成式 AI 快速演進的這幾年,以 ChatGPT、Gemini 等大型語言模型(LLM)為核心的工具早已進入我們的日常。我們不能只是知道「有這個東西」,更要理解它是怎麼運作的、該怎麼正確使用,才能真正幫助我們提升效率與競爭力。

這兩年我幾乎每天都在使用 AI,有時用得不錯,有時則總覺得哪裡卡卡的。我也看過不少 YouTube 或部落格的教學,從 prompt(提示語)設計到各種 AI 應用工具介紹,但總覺得缺了一個扎實的底層理解——到底模型怎麼想?它為什麼會這樣回答?我該怎麼跟它好好合作?

直到最近,在閱讀一份資料時,我注意到 Andrej Karpathy(前 OpenAI 核心研發成員、特斯拉 AI 團隊負責人)分享的一支影片:主題是「LLM 的應用與原理」。他用非常深入淺出的方式,說明了語言模型的底層邏輯、工具應用與常見誤解,也點出「怎麼正確地使用 AI」,才是真的有效率、有競爭力的使用。

這篇文章,就是我看完那部影片後的整理與反思,想寫給三種人:

- 對 AI 感到好奇,但還不知道從哪開始的人

- 已經在使用 AI,但懷疑自己是否真的用得對的人

- 關心未來職場發展、學習效率與永續競爭力的工作者與創新者

希望這篇內容,能幫你理解的不只是 AI,更是我們該如何與它共生共創的下一步。

1. LLM 是什麼?我們每天用的 AI 模型長什麼樣子?

大型語言模型(LLM)是一種能用自然語言與你對話的 AI,最知名的例子就是 ChatGPT。它的核心運作方式是透過大量閱讀網路資料、學習語言規則,並將這些知識壓縮在模型中,用來生成回應。你輸入一句話,它會根據上下文「預測」下一句最可能的內容。隨著技術演進,LLM 不僅能文字對話,還能看圖、聽聲音、上網搜尋、執行程式,甚至「記得」你的偏好。理解它的原理與用途,有助於我們更有效率、更有策略地運用 AI,打造未來的競爭力。以下是目前主流的大型語言模型(你可能早就聽過它們):

- ChatGPT(OpenAI):最廣為人知,也是功能最完整的模型

- Claude(Anthropic):擅長長文摘要、對話邏輯佳

- Gemini(Google):整合搜尋功能與 Google 生態系

- Copilot(Microsoft):與 Office 緊密整合,走企業生產力路線

- Meta 系列模型(如 LLaMA):開源生態的代表

- Grok(xAI):Elon Musk 推出的聊天模型

- DeepSeek / Mistral:亞洲與歐洲的新興代表

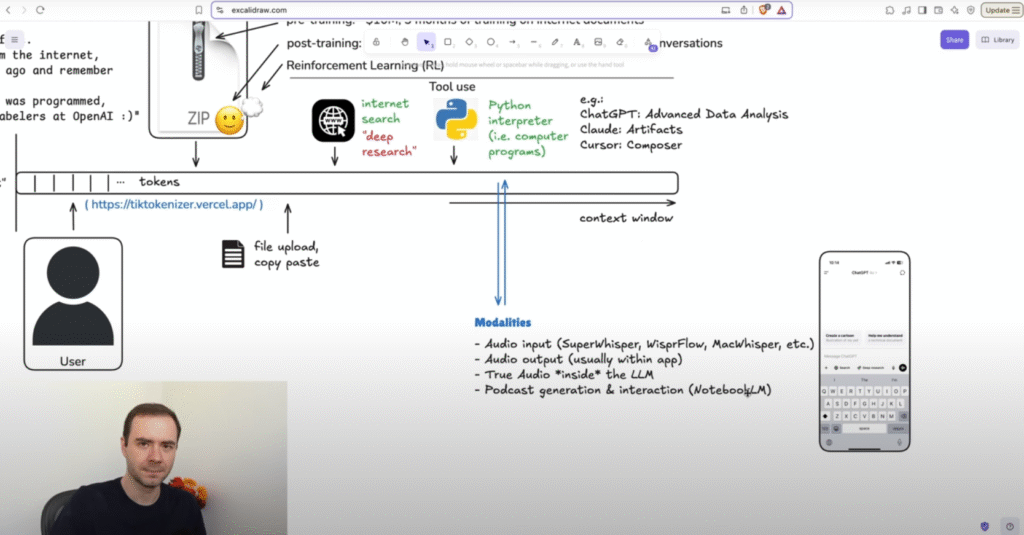

2. 原來 AI 是這樣「看懂」我們說的話:Token 與 Context

當你和 ChatGPT 或其他大型語言模型(LLM)對話時,其實模型不是在「看整段句子」,而是在處理一個個叫做 Token(符記) 的文字片段。

你可以把 Token 想像成模型讀語言的最小單位( AI 所能理解的「最小語言單位」)。舉個例子:當你請模型寫一首俳句,它可能回你:「words flow like a stream endless Echo never mind ghost of thought unseen」。這句詩意滿滿的回應,對我們來說是一整段話;但對模型來說,它是由 19 個 token 組成的語言拼圖,每一塊可能是:

- 一個單字(如:words, flow, stream)

- 帶空格的詞(如: unseen,注意前面有空白)

- 特殊標點(雖然這例子沒有,但「,」或「?」也會被算進去)

更有趣的是,“Echo” 跟 “echo” 在模型眼中是不同的 token,因為它是區分大小寫的。

備註:LLM 背後其實有個超大的「詞彙表」(約 20 萬個 token),每個 token 對應一組 ID。模型就是靠這些 ID 做運算,進行理解與回應。如果你想親自看看一句話會被切成哪些 token,可以用像 Tiktokenizer 這樣的工具試試看,會很驚喜。

接著,LLM 會把這些 token 存在一個叫做 Context Window(上下文視窗) 的記憶區塊中,記錄你和它之間的對話內容。這就像它的「工作記憶」:能讀得越多,就越能理解上下文。

不過,Andrej Karpathy提醒到「記憶空間是有限的!太多 token 會讓模型「分心」或變慢,甚至降低回答品質」。因此,當你切換話題時,最好的做法就是「開始新的對話」,讓模型可以重新聚焦,幫助它更快、更準確地回答問題。

理解 token 和 context window,是讓 AI 回答變聰明的第一步,而實際使用的注意事項:

該開新對話視窗就開,不要硬把好幾個主題塞在同一段裡

錯誤示範:

「幫我寫請假信、整理開會紀錄、修改簡報、順便介紹AI寫程式工具」

→ 太多任務會讓AI混亂,容易漏重點。

正確做法:

每個任務開一個新對話,清楚聚焦。

提問要簡潔明確,讓 AI 不會被 context 擠爆而失焦

錯誤示範:

「我最近想離職又不想,你覺得怎麼辦?我們公司文化也怪怪的…」

→ 問題模糊,AI難回答。

正確做法:

賦予AI角色,並從大問題問到小問題,如:「你是一個HR顧問,你會怎麼幫助人們判斷離職的時機?」、「你是一個HR顧問,公司文化有問題怎麼辦?」

這樣 AI 才能針對重點給出實用建議。

模型是有限資源,不要讓它為了找重點而浪費太多 token

錯誤範例:

「以下是我十幾頁的訪談逐字稿,我想請你幫我找出最重要的三個觀點。」(貼上大量未整理的原始對話內容)

問題點:

這會塞爆 AI 的上下文視窗(Context Window),導致它花很多 token 在讀文字而無法深入分析,甚至可能截斷資訊或出錯。

正確行為:

- 先自己做初步整理,如:「這是三段訪談摘要,我已用編號標記,請幫我從中找出共通主題。」

- 或 分段分次給 AI:「這是第一段訪談(約 400 字),幫我萃取三個重點觀點。等你整理完我再貼第二段。」

這樣既節省 token,也讓 AI 表現更準確。

3.當 AI「亂講話」時:它不是在騙你,而是在猜

有時候,你可能會遇到這種情況:

你問 AI:「兩種藥物的成分有什麼差異?」

它回答得頭頭是道,連化學名稱都列給你,但你查一下包裝——嗯?根本對不上。這不是 AI 惡意說謊(不是有人故意植入錯誤的資訊),也不是它壞掉了。這是所謂的 「幻覺(hallucination)」現象——當模型給出看起來合理、實際錯誤的答案時,就叫做幻覺。

那麼,AI 為什麼會幻覺?又該怎麼應對呢?Andrej Karpathy分享了幻覺得原因以及建議的應對方式

為什麼模型會「亂猜」答案?

1. 模型太小,知識太淺:類似「小學生硬要回答博士題目」,聽起來有自信,但其實不懂。小型模型(或老舊版本)在知識廣度與推理能力上本來就比較弱,當它遇到超出理解範圍的題目時,就會「掰一個答案出來」。

2. 沒有工具,硬要靠想像力:亂接答案,接的順不代表接的對。生成式AI的回答,是在「接龍」;意思是他會計算接下來比較高比率的文字,例如當偵測到「台灣小」,後面比較會接「吃」。所以靠大數法則,通常都會接的順,但有時就不一定接的對。特別是,有些問題需要模型動手算,比如:複雜的乘法、統計運算、資料視覺化。如果模型沒有配備 Python 解譯器 或資料查詢工具,它只能靠記憶模糊地「亂接」。

3. 模型知識是「模糊壓縮記憶」:這點就像人類:對不熟的事會憑印象回答,只是模型不會告訴你它其實不確定。如前所述,LLM 的知識來自於預訓練階段的資料壓縮,而不是準確記憶。當它找不到明確資訊時,就會用「最有可能是這樣」的方式來推斷,這就很容易猜錯。

防幻覺的 4 建議

一律查核重要答案,不信就查

正確做法:親自核實,點開網站確認資訊

模型的回答不等於事實。尤其是牽涉健康、財經、法律等高風險內容時,一定要查來源、比對資料

模型會寫程式?你還是得檢查

正確做法:相信它有幫忙,但也請你當個嚴謹的主管。

即使你讓 AI 幫你畫圖、跑統計、做資料分析,也請把它寫的程式碼當成實習生交來的作業。它可能會:預設錯誤變數、忘了處理例外狀況、用過時的方法

「深度研究」≠ 絕對可信

正確做法:對待這些研究結果,建議視為「參考草稿」,而非最終版本

有些模型會標榜「具備研究功能」,甚至提供引用文獻。但影片提醒我們:這些引用不一定真的存在,有時是模型「模擬出來的看起來像真的文獻格式」

選對模型,別硬逼它做它不擅長的事

正確做法:就像請顧問開會,要找對人,而不是讓品牌響的如果你需要準確運算、複雜邏輯、或資料處理,請優先使用:

- 有查詢工具的版本(如開啟 browsing 模式)

- 具備 Python 解譯器 的模型(如 ChatGPT Pro)

- 支援多步驟推理的模型(如 Claude 3.5 或 GPT-4o)

總之,AI 不是萬能的資訊精靈,它比較像是一位見多識廣但偶爾亂猜的助手。

你對它越了解,它就越能成為你工作與學習的好幫手,而不是出錯時讓你白忙一場的「嘴砲機器」。

4. 模型會「思考」?進階 AI 工具的應用與選擇指南

用過深度研究等進階功能的人可能會驚訝感嘆:「AI好像越來越聰明了耶!」事實上,現在的AI 模型真的開始導入「思考」的模式,它開始學會使用工具來幫助自己查資料、算數學,甚至閱讀整本 PDF 書。

以下,Andrej Karpathy分享幾個關鍵的進階功能與概念,幫助你依據情境,精準使用模型。

思考型模型:AI 真的「動腦」了

所謂的思考型模型(thinking models),是指一種「強化學習(Reinforcement Learning)」的 AI。這是相對較新的訓練技術,幫助模型學習解決複雜問題時的「最佳思考策略」。有用的此技術的模型,如:

- OpenAI 的「O」系列模型:影片中明確指出,O1、O3 mini、O3 mini high 和 O1 Pro 都是思考性模型。其中 O1 Pro 被認為在推理方面表現最佳,但需要支付每月 200 美元的最高訂閱費用才能使用。

- Grok:Grok 具備一個名為「Think」的模式。當你啟用這個模式時,Grok 會在幕後切換到它的思考性模型。

- Perplexity.ai:Perplexity.ai 平台上託管了 Deepseek R1 模型,這是一個具備推理能力的模型。(在影片中有展示 Deepseek R1 如何透過「思考」來解決一個程式問題,並顯示其內心思考的過程)。

在強化學習過程中,模型會針對大量的練習問題(尤其是數學和程式碼問題)進行練習,並發展出「思考策略」。這些策略非常類似於人類在解決問題時的「內心獨白」,例如模型會嘗試不同的想法、回溯、重新審視假設等等。簡而言之,它不只是回應,而是會像人一樣「先停下來想一想」。例如在解數學題目時,它會類似這樣處理:「這個地方應該要這樣計算、應該要運用這個方程式……等等,這樣計算出來結果是錯的,好像是有個方程式運用錯誤了?需要重來一次。」

由於啟用思考模式後,模型會進行更多思考,因而能帶來更高的準確性,特別是在處理數學、程式碼以及需要大量邏輯思考的困難問題時,效果特為顯著。因此,這類模型擅長處理邏輯密集、步驟複雜的任務,例如:

- 數學推理(特別是多步驟)

- 程式碼理解與生成

- 法律或科學條文的推理與對照

相對的,因為思考模式會產生大量 tokens,處理時間會拉長,回答可能需等 1~2 分鐘,且高精準的模型費用相當高(GPT-4o O1 Pro 每月訂閱費高達美金 $200),故簡單查詢或文章語句優化的應用就建議直接使用4o的模型,而不是思考模型。

最後,即使是進階模型,也可能出現幻覺或錯誤推理。產出的內容應當作「草稿」,尤其是科研、程式、醫療等高風險領域,一定要自行驗證。

深度研究:思考模式、搜尋與文句梳理的結合

有些高階 AI 模型,甚至具備所謂的深度研究(Deep Research)能力。這個功能的重點在於:它不只查一次資料,而是像人類研究員一樣「查很多次、反覆比對、產出整理好的報告」。

運作流程會長這樣:

- 幫你在網路上查多個來源

- 整理成有邏輯的段落與摘要

- 提供參考文獻(雖然不一定 100% 精準)

用在哪些情況最適合?

- 探討某個成分的作用與安全性(如長壽產品 C-AKG)

- 比較兩個產品的差異(如 Brave vs Arc 的瀏覽器隱私比較)

- 幫你建立某個領域的初步理解(如 LLM 公司的融資狀況)

不過,這份報告雖然「看起來很像論文」,但仍可能包含錯誤引用或幻覺內容,千萬不要直接複製貼上引用,要當作初稿或備查資料來使用。

5.AI 會越來越像你嗎?打造你的專屬AI的三個方法

如果你跟 AI 聊得越來越順,有時候甚至覺得它「懂你」了,不是錯覺。因為現在的 LLM,真的能開始「記住你」,甚至根據你的使用習慣、風格與需求來個人化回應。這就是 Karpathy 在影片中提到的三個關鍵功能:記憶、自訂指令,以及自訂 GPTs。這些功能合在一起,會讓你感受到:AI 不再只是聊天機器,而是變成你熟悉的、會幫你省事的個人助理。

記憶功能(Memory)是 ChatGPT 的獨家特點,讓 AI 能記住你過去的偏好與資訊,打造更貼近你的個人化互動體驗

記憶功能(Memory)— 讓 ChatGPT 記得你是誰

這是 ChatGPT 的專屬功能,它可以自動記下你在對話中透露的資訊(例如你的工作、偏好、語氣喜好),並在未來的所有對話中自動使用這些設定。就像一位長期合作的助理,不需要你每次都重頭說明自己是誰。

舉例而言,若你說「我不喜歡太官方、請簡單說人話」,它會記得在後續回應中保持輕鬆語氣;若你說「我是一位台灣的服務設計顧問」,它下次就會自動帶入這背景,幫你推薦更符合場域的做法。

設定方式:

- 點選 ChatGPT 左下角你的帳號 > Settings(設定)

- 選擇「Personalization(個人化)」

- 點選「Memory(記憶)」> 開啟功能

- 系統會在記下重要資訊時通知你(例如:「我會記得你是老師」)

- 想修改時,可以點「Manage Memory」查看與刪除

自訂指令(Custom Instructions)— 讓你控制語氣與角色設定

這是讓你明確告訴 ChatGPT:你是誰 + 你希望它怎麼說話、怎麼幫你的功能。比記憶功能更主動、一次性設定完成,非常適合剛建立新對話或還不想開記憶功能的人。

舉例,「我是一位教大學生的老師,請你給我適合他們程度的教材建議」、「請你回應時都用簡單易懂的語氣,避免過度學術化」、「我希望你在每次提供旅遊建議時都列出預算估算與交通時間」

設定方式(下圖提供我的舉例):

- 點選左下角帳號 > Customize ChatGPT(自訂 ChatGPT)

- 會看到三個欄位:

- 如何稱呼你

- 你的職業

- ChatGPT應具備的特質

- 輸入後,點選「儲存」。

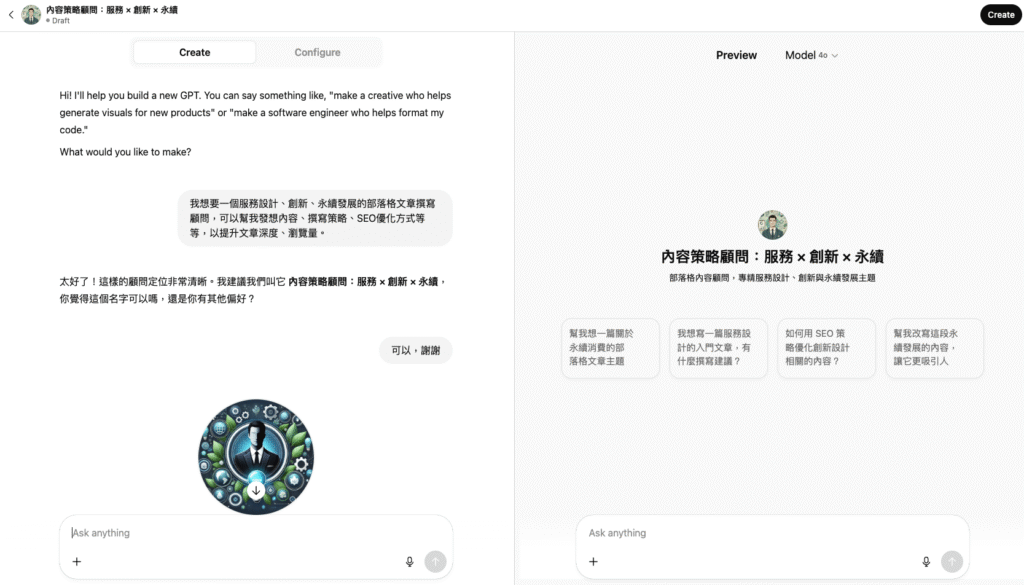

自訂 GPT 助理(Custom GPTs)— 建立個人任務 AI 工具

這是功能最強大的個人化選項,你可以建立屬於自己的 GPT 助理,設定它的「角色、用途、語氣」,還可以上傳資料或連接 API,讓它專門完成某一類任務。簡單說,就是把 ChatGPT「訓練成」你某個固定任務的專屬助手。舉例如下:

- 資料查找助理 GPT:幫你把輸入資料轉為表格、摘要並附註來源說明。

- AI 翻譯小幫手 GPT:自動中英翻譯、加上拼音與語法說明。

- Podcast 整理 GPT:輸入逐字稿,它會幫你抓重點、分類段落、產出摘要。

- 企業 ESG 諮詢 GPT:上傳永續報告範例,它就能依照格式建議貴公司的草稿。

建立步驟(下圖提供我的舉例)

- 將ChatGPT的語言改為「英語」(我發現中文介面目前還不支援這個功能)

- 點點右上角「Create」

- 依序填寫:

- 這個 GPT 是誰(角色設定,例如「韓文老師」、「ESG 顧問」)

- 它的任務是什麼(像是幫你轉檔、分析文本、產出學習表格)

- 要不要上傳檔案或連 API

- 完成後即可命名、測試使用,還可分享連結給他人

6. 如何更聰明地使用 LLM:策略、習慣與心態建議

在影片的最後,Karpathy 提供了一系列非常實用的「使用建議」,這些不是寫程式或 prompt 的高深技巧,而是你我都可以立刻上手的小習慣與好心態,幫助我們更有效率地與 LLM 合作、也更安全地信任它。

日常使用的 8 個實用建議

- 切換話題,就換個對話:新的任務請「重新開一個 chat」,可以避免前一段的內容干擾模型,提升準確度,也降低 token 成本。

- 看清楚你在用哪個模型:不同模型差很大,不只是價格不同,回答風格、知識範圍、幻覺機率也會有差異。

- 高風險資訊一定要驗證:不管是健康、法律、投資還是程式碼,模型的話都不能盲信,請回頭查資料。

- 搞懂你的工具箱:有些模型可以搜尋、有些可以計算、有些可以畫圖,不會自己上網查的模型自然答不出最新的新聞。

- 挑對模型來「思考」:簡單問題用普通模型,但遇到複雜邏輯、程式、數學,建議切換到思考型模型。

- 語音比打字還快:如果你在手機上用 LLM,試著多講話少打字——Karpathy 說一半以上的使用者查詢是語音輸入的。

- 提供範例效果加倍:不管是 prompt 還是自訂指令,有提供「具體例子」時,模型更容易懂、答得更準。

- 打造你的「LLM 顧問團」:不確定的時候,同一題可以問兩三個模型交叉比對,效果比單一模型好得多。

最後,為什麼這和永續有關?

我們總以為永續只和環保、碳排、資源再生有關。

但在這個知識瞬息萬變、工作型態快速演化的年代,一個人能否「有效使用 AI」、能否持續學習並建立與工具共生的能力,本身就是一種永續競爭力。

在Karpathy 的影片是透過深入淺出的說明,幫助我們每個人「理解 AI,並能更有效的開始使用AI」。因為只有這樣,我們才不會被甩在未來工作的門外,才有機會把這些技術轉化成自己的生產力、創造力與判斷力,並在社會中保持永續的競爭力。